CHARCHA проверит личность за экраном перед генерацией контента.

Специалисты из Университета Карнеги-Меллона и Массачусетского технологического института (MIT)

Система CHARCHA (Computer Human Assessment for Recreating Characters with Human Actions) позволяет пользователям безопасно воссоздавать свое изображение в нейросети, решая проблемы несанкционированного использования дипфейков.

Разработчики CHARCHA

Процесс живой проверки, который занимает около 90 секунд, анализирует действия, чтобы убедиться, что за экраном живой человек и что он выполняет правильные запросы. Весь процесс занимает около 90 секунд и проходит в режиме реального времени.

Анализируя выполнение заданий, программа подтверждает, что перед камерой находится реальный человек, а не записанный заранее видеоролик или статичное изображение. После успешного прохождения процедуры изображения используются для обучения внутренней модели генерации контента. Таким образом, пользователи самостоятельно дают разрешение на создание своего цифрового образа и сохраняют контроль над собственными данными.

Авторы исследования отметили, что CHARCHA разработан в ответ на стремительное распространение генеративного ИИ и связанные с ним угрозы конфиденциальности. Система позволяет людям контролировать использование их образа без необходимости полагаться на сторонние платформы и их политики хранения данных.

Разработка была

Специалисты из Университета Карнеги-Меллона и Массачусетского технологического института (MIT)

Для просмотра ссылки необходимо нажать

Вход или Регистрация

новую технологию для защиты личных данных пользователей при создании генеративного контента.Система CHARCHA (Computer Human Assessment for Recreating Characters with Human Actions) позволяет пользователям безопасно воссоздавать свое изображение в нейросети, решая проблемы несанкционированного использования дипфейков.

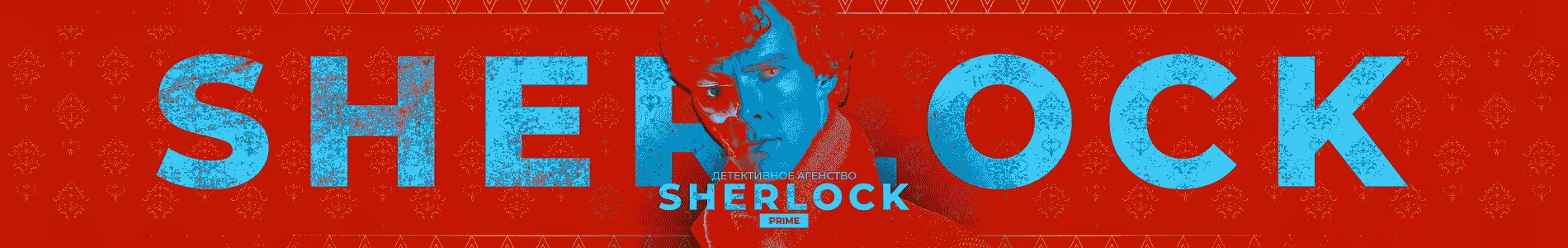

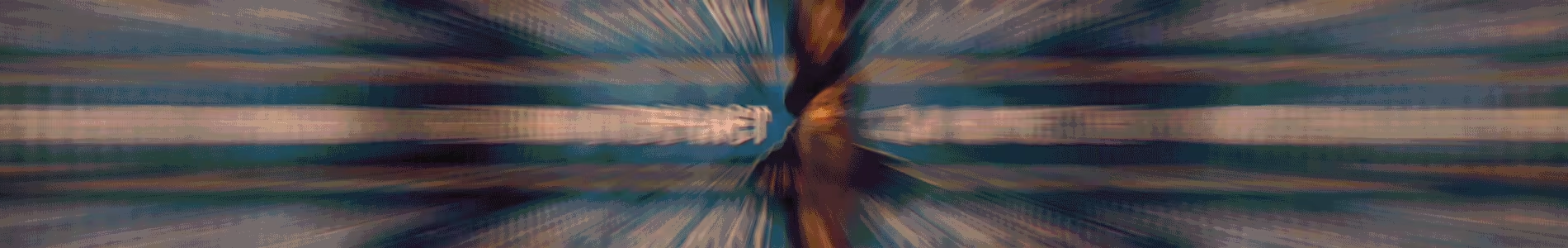

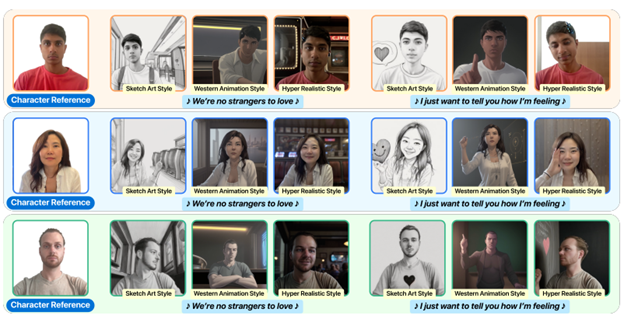

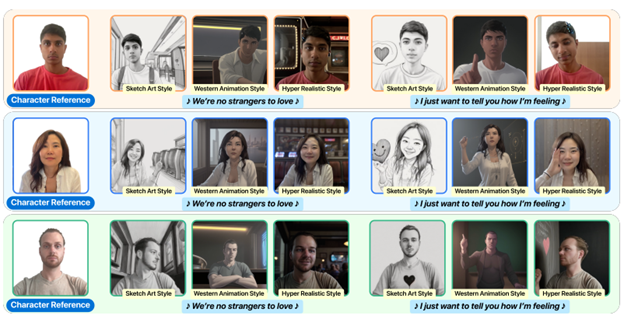

Кадры и тексты песен из сгенерированных музыкальных клипов для песни «Never Gonna Give You Up» с отсылкой к персонажам из CHARCHA (arXiv)

Разработчики CHARCHA

Для просмотра ссылки необходимо нажать

Вход или Регистрация

концепцией CAPTCHA, применяемой для защиты от ботов. Однако вместо текстовых или графических тестов система использует физические взаимодействия. Пользователю предлагается выполнить случайный набор движений перед веб-камерой, например, повернуть голову, прищуриться или улыбнуться с приоткрытым ртом.Процесс живой проверки, который занимает около 90 секунд, анализирует действия, чтобы убедиться, что за экраном живой человек и что он выполняет правильные запросы. Весь процесс занимает около 90 секунд и проходит в режиме реального времени.

Анализируя выполнение заданий, программа подтверждает, что перед камерой находится реальный человек, а не записанный заранее видеоролик или статичное изображение. После успешного прохождения процедуры изображения используются для обучения внутренней модели генерации контента. Таким образом, пользователи самостоятельно дают разрешение на создание своего цифрового образа и сохраняют контроль над собственными данными.

Авторы исследования отметили, что CHARCHA разработан в ответ на стремительное распространение генеративного ИИ и связанные с ним угрозы конфиденциальности. Система позволяет людям контролировать использование их образа без необходимости полагаться на сторонние платформы и их политики хранения данных.

Разработка была

Для просмотра ссылки необходимо нажать

Вход или Регистрация

на конференции NeurIPS 2024, где вызвала интерес среди представителей индустрии. Авторы CHARCHA подчёркивают, что в перспективе подобный подход может изменить отношение пользователей к генеративным нейросетям и сделать их более доверительными.

Для просмотра ссылки необходимо нажать

Вход или Регистрация