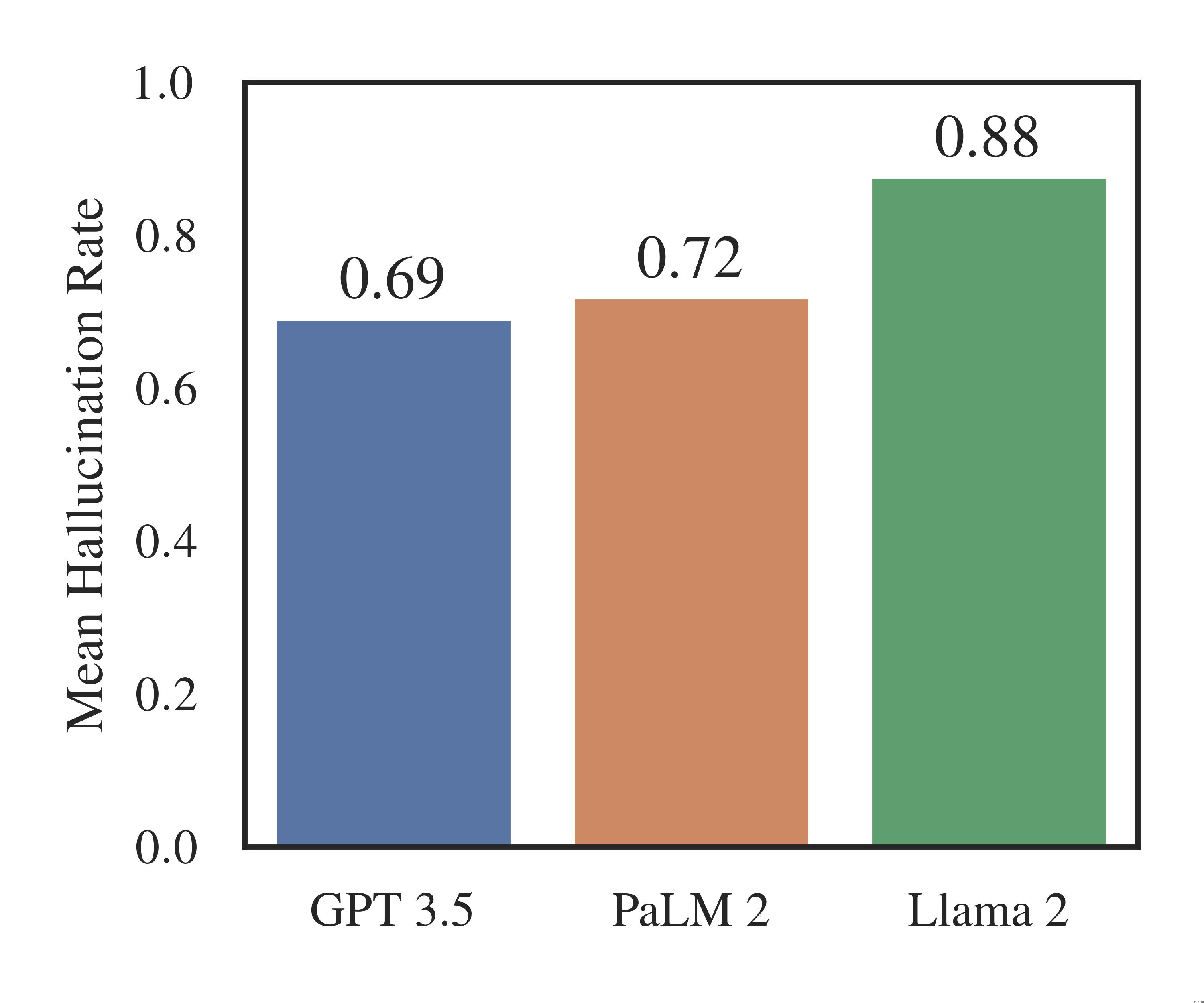

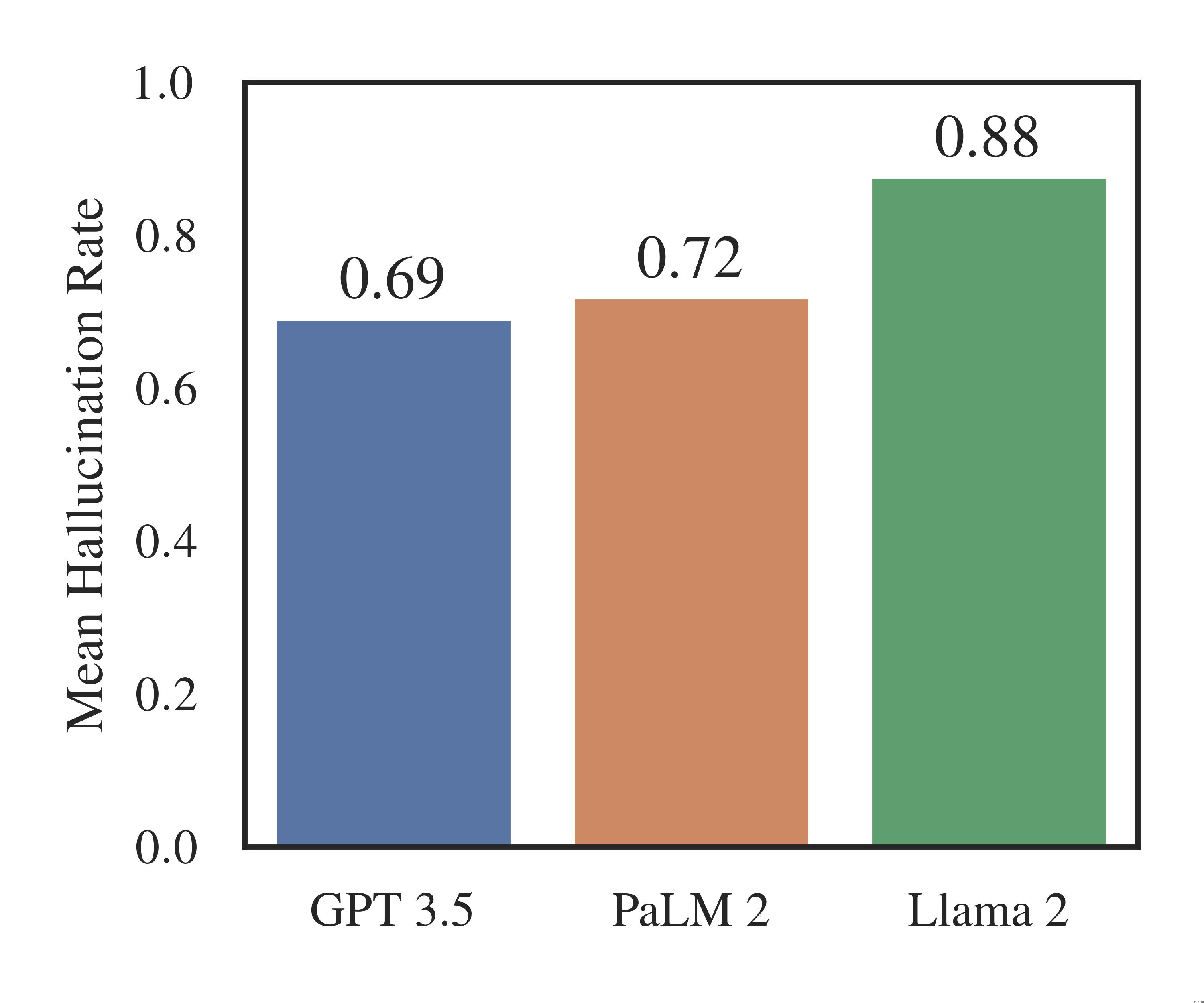

ИИ фантазирует на тему прецедентов и не может провести юридический анализ в 69–88% случаях, говорится в исследовании университета.

Стэнфордский университет (США)

Особое затруднение у нейросетей вызывало прецедентное право в судах низшей инстанции, например, в окружных судах. Исследователи отметили, что на сложные вопросы, требующие владение терминологией и юртехникой, ИИ также чаще отвечал неправильно. Например, не мог ответить о преимуществе одного прецедента над другим. В университете делают вывод, что искусственный интеллект еще не способны проводить юридический анализ ситуации, который осуществляют в своей работе адвокаты.

Еще одним недостатком технологий ИИ стало то, что программы могут делать ошибончые выводы из изначально некорректного запроса пользователя. Если фактическая ошибка содержалась в вопросе клиента,то нейросети не исправляли ее, а продолжали неверную цепочку рассуждений.

Исследователи резюмируют, что интеграция технологий искусственного интеллекта в юридическую практику должна осуществляться под тщательным контролем человека.

Стэнфордский университет (США)

Для просмотра ссылки необходимо нажать

Вход или Регистрация

результаты исследования, в котором изучил ответы генеративных систем искусственного интеллекта на юридические вопросы. Ученые указывают, что в 69–88% случаях площадки отвечает неверно на вопросы о судебной практике и конкретных кейсах.- ChatGPT, GPT-3.5 от Open AI ошибся в 69 % случаев.

- Программа PaLM 2 от Google давала неверные ответы на 72 % вопросов,

- а Llama 2 от Meta — 88 %.

Особое затруднение у нейросетей вызывало прецедентное право в судах низшей инстанции, например, в окружных судах. Исследователи отметили, что на сложные вопросы, требующие владение терминологией и юртехникой, ИИ также чаще отвечал неправильно. Например, не мог ответить о преимуществе одного прецедента над другим. В университете делают вывод, что искусственный интеллект еще не способны проводить юридический анализ ситуации, который осуществляют в своей работе адвокаты.

При этом нейросети продолжали генерировать недостоверный контент, убеждая пользователя в собственной компетентности.

Еще одним недостатком технологий ИИ стало то, что программы могут делать ошибончые выводы из изначально некорректного запроса пользователя. Если фактическая ошибка содержалась в вопросе клиента,то нейросети не исправляли ее, а продолжали неверную цепочку рассуждений.

Исследователи резюмируют, что интеграция технологий искусственного интеллекта в юридическую практику должна осуществляться под тщательным контролем человека.

Для просмотра ссылки необходимо нажать

Вход или Регистрация